Preceding Conceptual Tech

Basics of Machine Learning

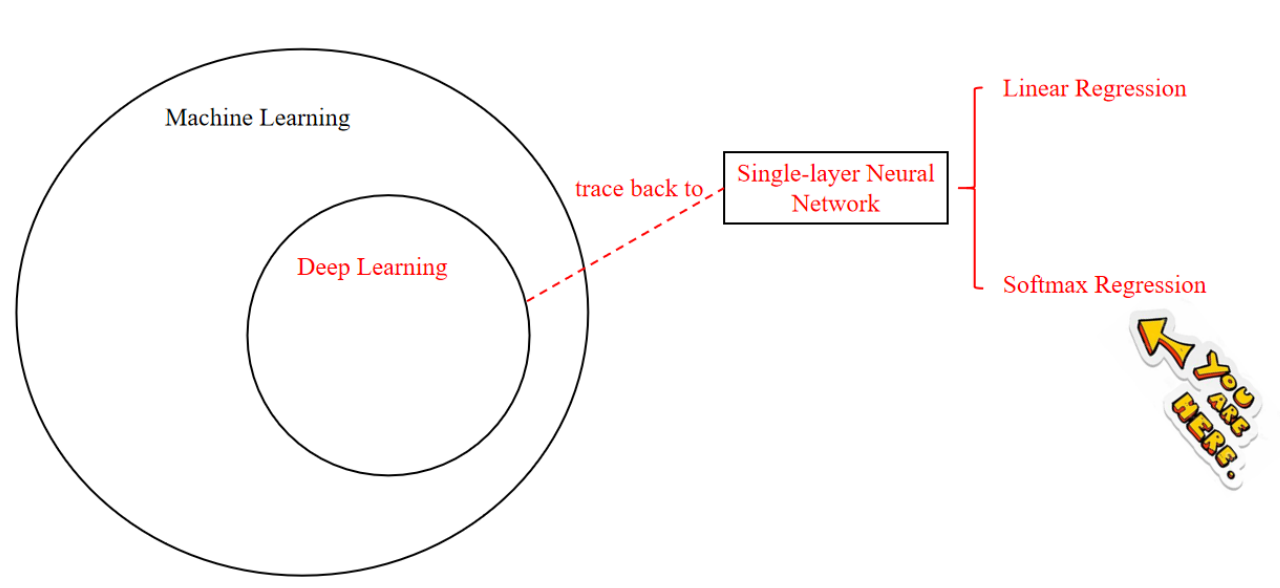

Softmax 回归:这是一种用于多类分类问题的回归方法,通常用于神经网络的输出层。

Softmax 与深度学习的关系:Softmax 回归是深度学习中的一个重要组成部分,特别是在处理分类问题时。它与线性回归和单层神经网络有联系,并可以追溯到深度学习的更广泛背景中。

1. Softmax 回归解决了什么问题?

- 解决多分类问题。

线性回归在分类问题上的局限性

Linear Regression-->Discrete Classification

Problem: In the process of converting continuous values to discrete values, there is usually an element of experience. If the error is large, it will greatly affect the quality of classification. During the conversion process, it is easy for people to think of setting a threshold. Setting the threshold based on experience will bring a lot of uncertainties, and the quality of classification is also related to the different experiences of different people.

输出每种情形的概率值

Software Regression--->Discrete Classification

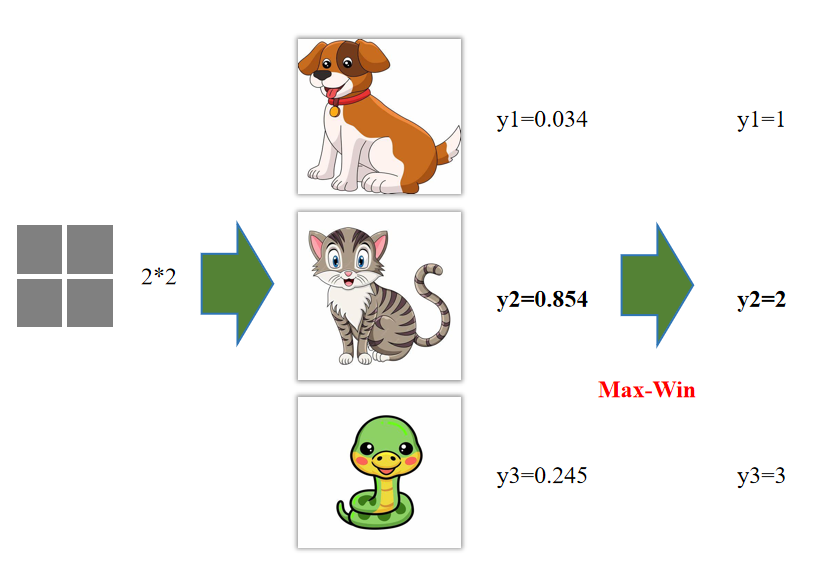

VS: Linear regression only outputs one value, while softmax outputs multiple values, and the number of output values is consistent with the number of categories.

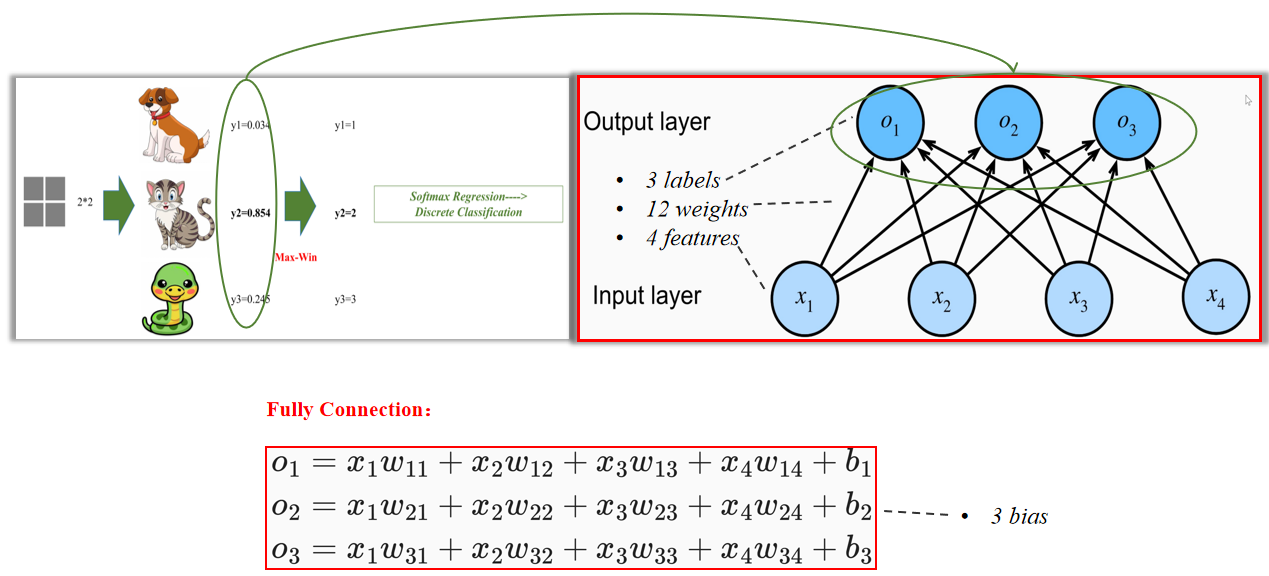

2. Soft Regression 长啥样

3. 输出结果

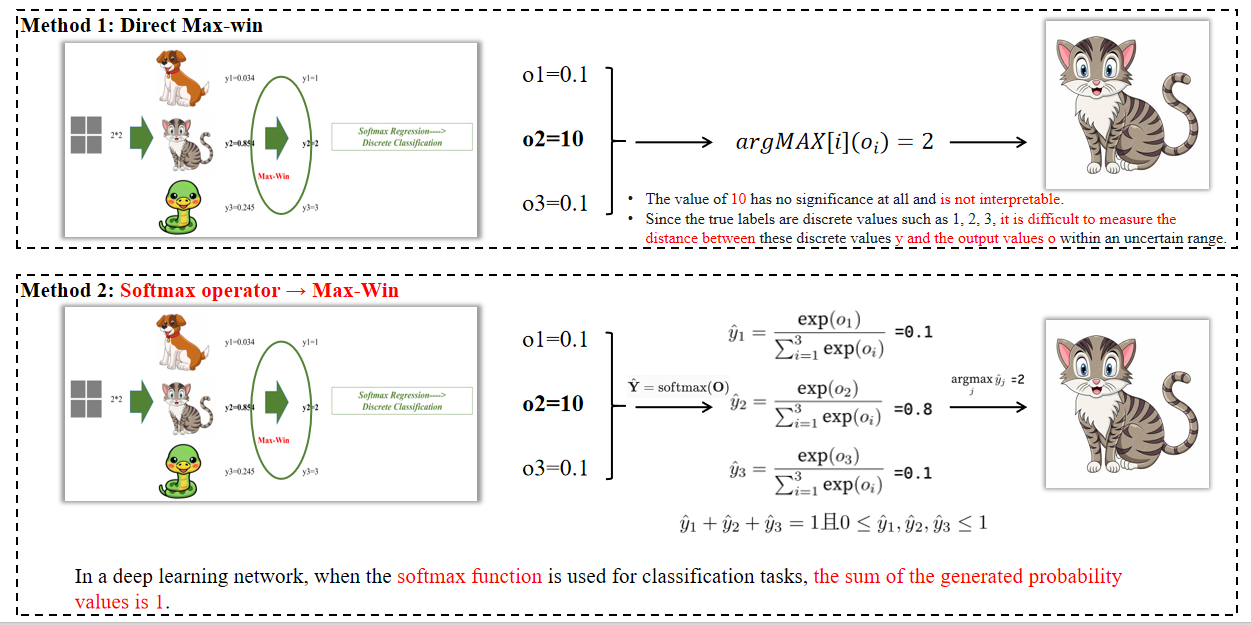

方法1:直接最大概率(Max-Win):选择概率值最大的类别作为分类结果。例如,如果类别2的概率最高(如0.854),则选择类别2。

**方法2:Softmax operator Max-Win **:首先通过Softmax函数将原始输出转换为概率分布,然后选择概率最大的类别。例如,Softmax函数将原始输出转换为概率值(如0.1, 0.8, 0.1),然后选择概率最大的类别(如0.8对应的类别2)。

4. 数学公式

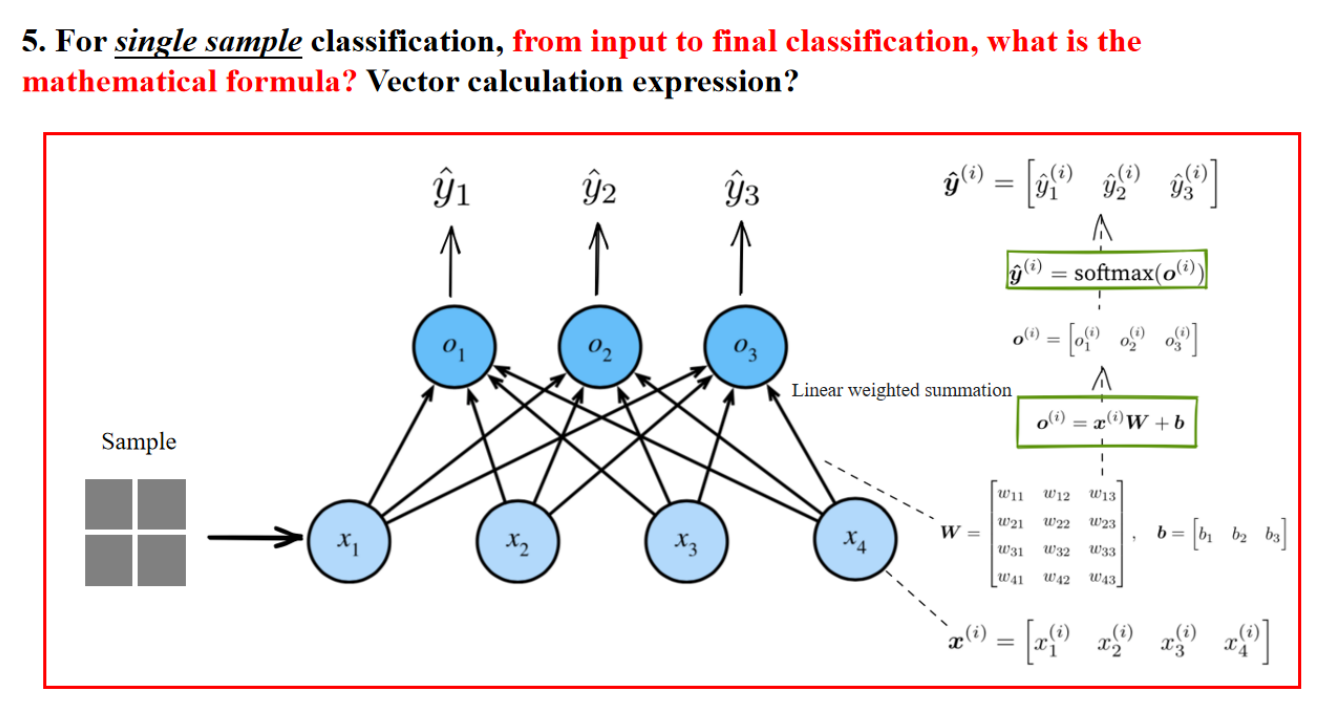

For single sample classification, from input to final classification, what is the mathematical formula? Vector calculation expression?

对于单一样本分类,从输入到最终分类的数学公式是什么?向量计算表达式?

以上是数学过程。

下面是解释:

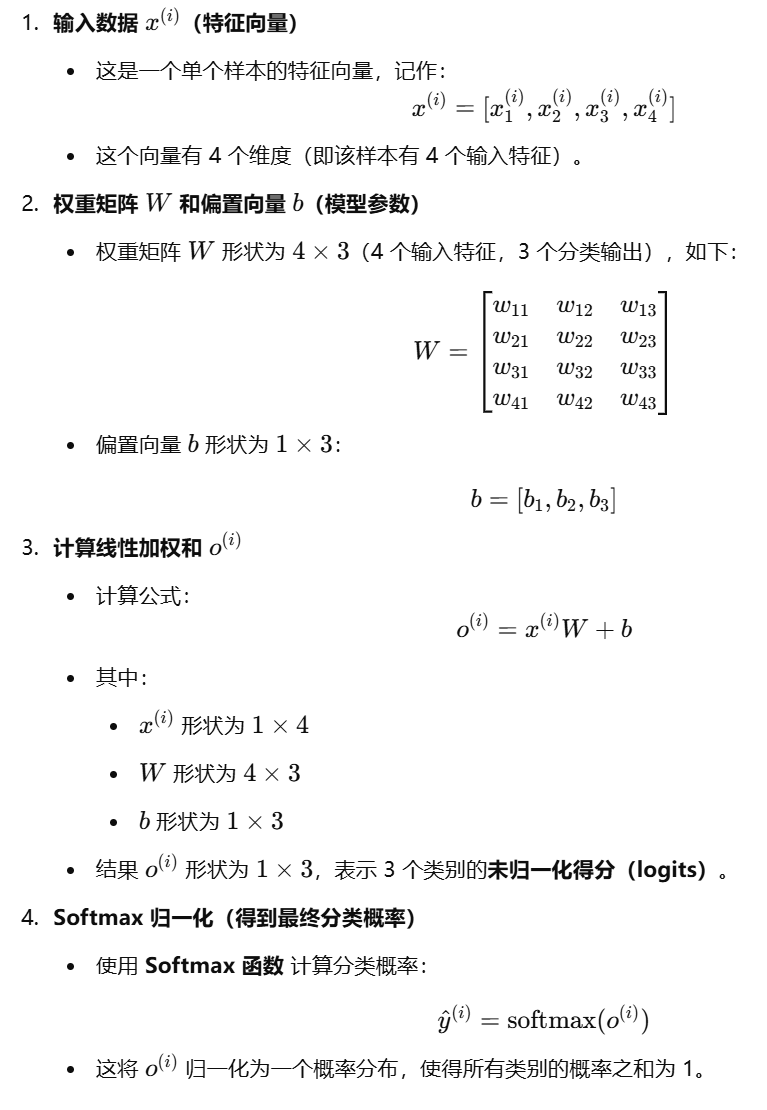

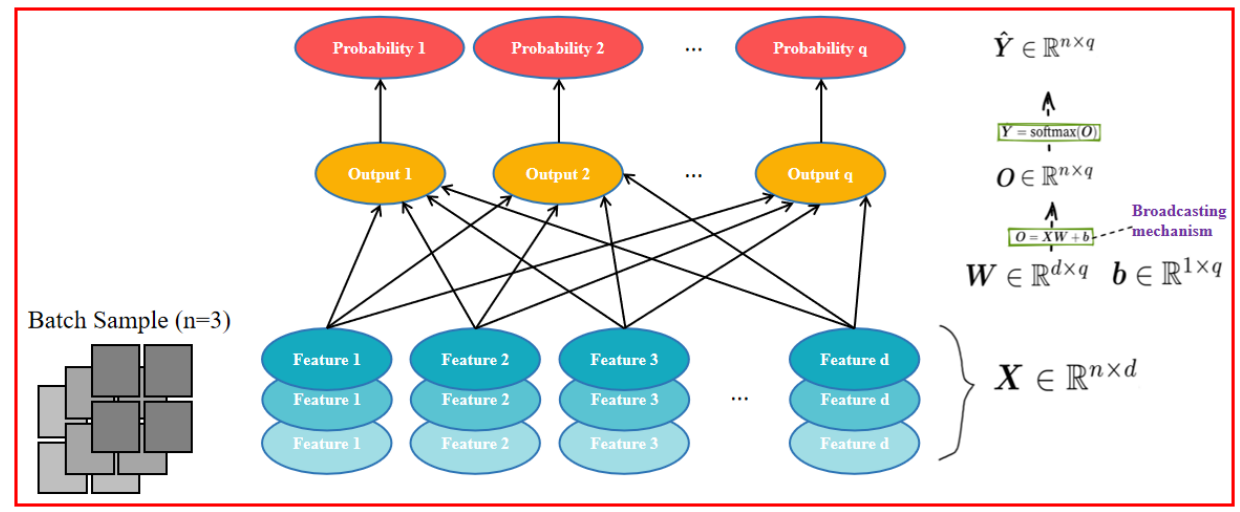

5. 小批量样本分类

For small batch sample classification, from input to final classification, what is the mathematical formula? Vector calculation expression?

对于小批量样本分类,从输入到最终分类,数学公式是什么? 数学公式?向量计算表达式?

5.1 图片解释数学公式

输入数据

- 形状:

权重矩阵

- 形状:

偏置项

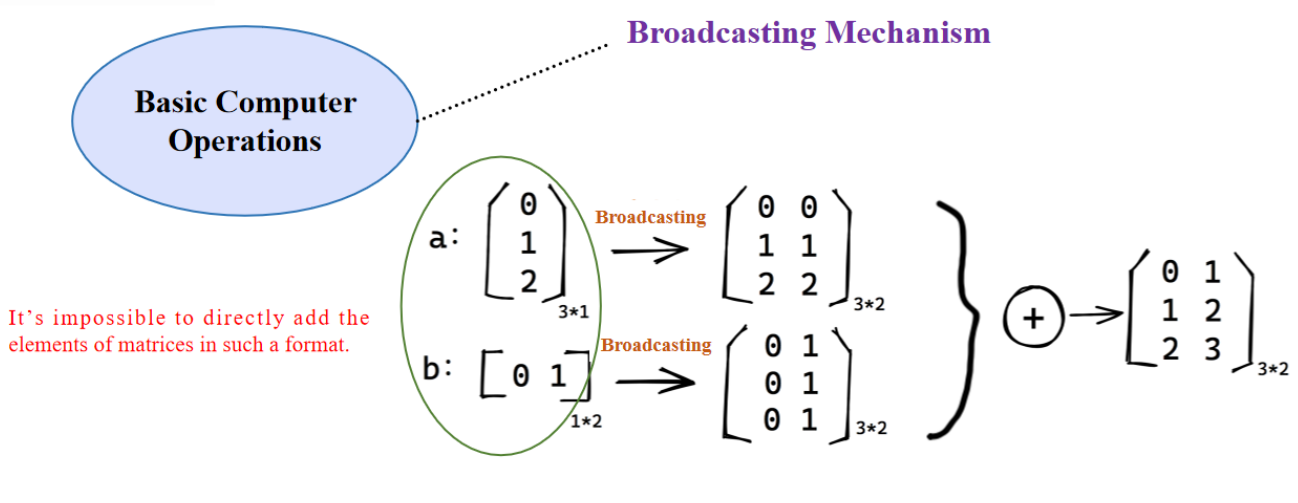

- Broadcasting 机制:由于

线性变换

- 计算公式:

- 形状:

Softmax 归一化

- 计算公式:

- 含义:

- 对于每个样本的

- 生成一个概率矩阵,其中

- 对于每个样本的

- 形状:

5.2 Broadcasting Mechanism

- 允许不同形状的张量进行数学运算(如加法)。

- 例如:

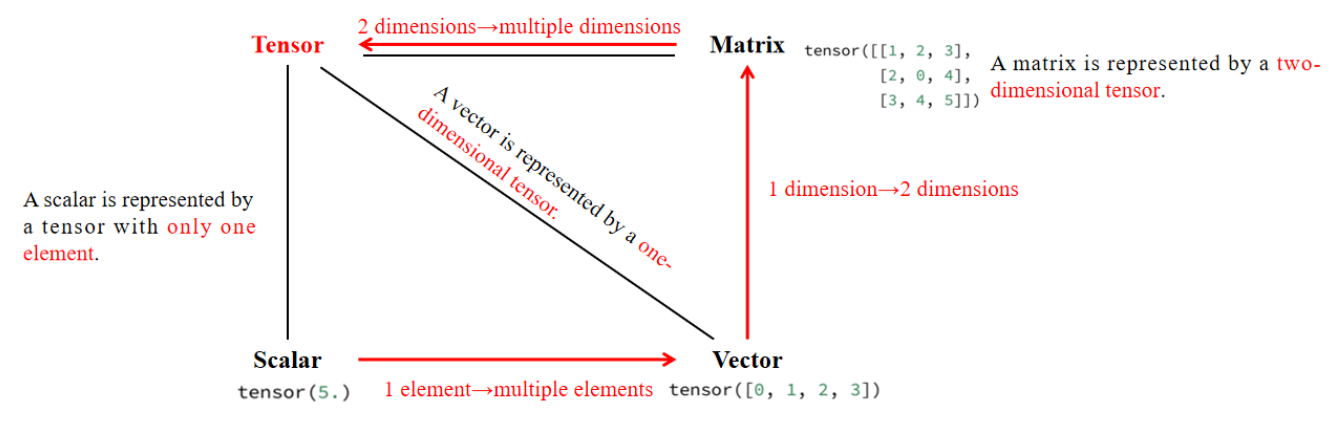

5.3 Linear Algebra Basics

张量(Tensor) 是更高维度的矩阵:

- 标量(Scalar):单个数值,形状

- 向量(Vector):一维数组,形状

- 矩阵(Matrix):二维数组,形状

- 高维张量(Tensor):三维及以上的数组,形状

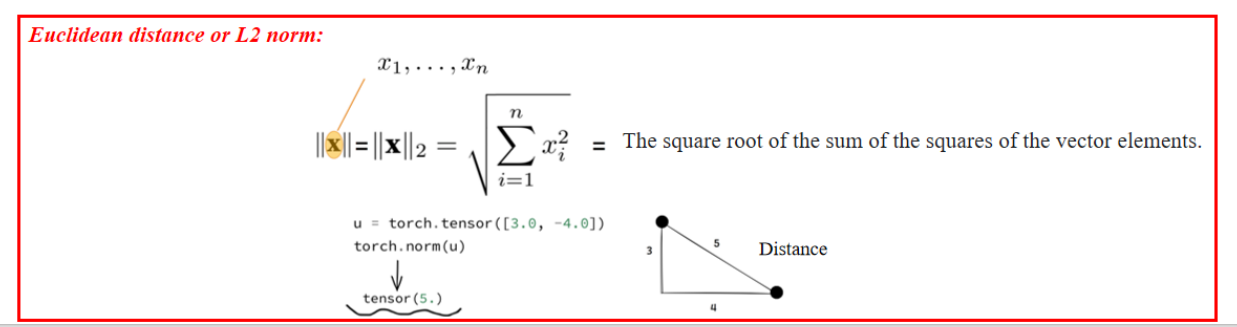

L2 范数(欧几里得距离)

- 计算方式:平方和开方。

- 物理意义:向量的长度或欧几里得距离。

- 深度学习中用于衡量误差,如 MSE(均方误差)。

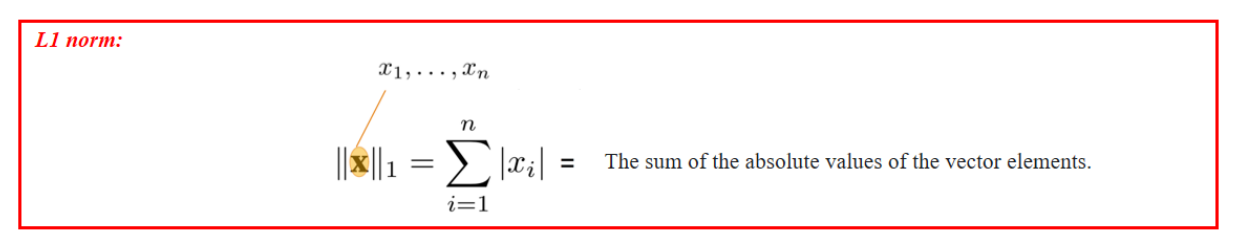

L1 范数(曼哈顿距离)

- 计算方式:绝对值之和。

- 物理意义:坐标轴上的步数距离。

- 机器学习中用于 L1 正则化,使权重稀疏化(Lasso 回归)。

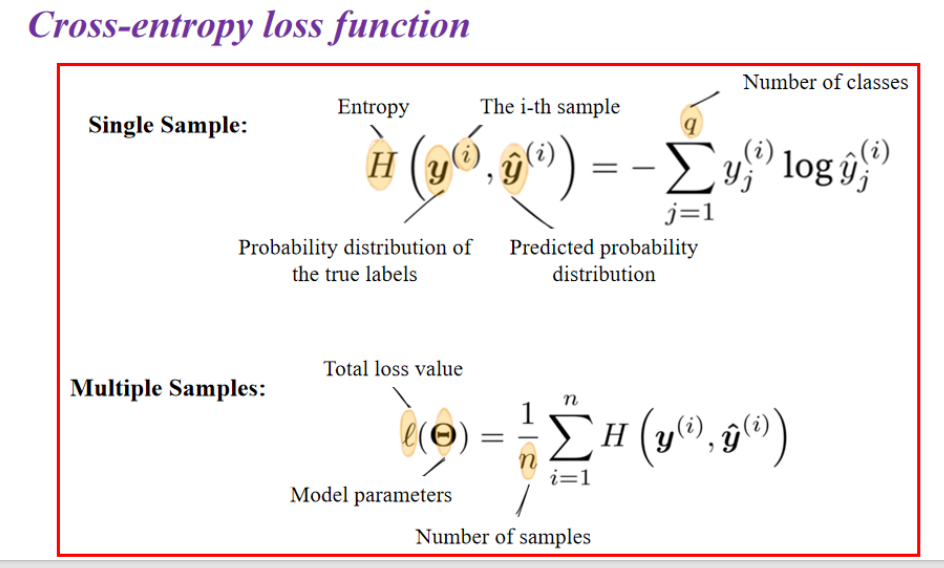

6. 交叉熵损失函数

During training, how to make the predicted probability value distribution as close as possible to the real label probability distribution? When testing, how to measure the effectiveness of predictions?

6.1 损失函数

单样本(Single Sample)交叉熵

对于第

多个样本(Multiple Samples)交叉熵

对于一批样本(batch),我们对所有样本的交叉熵取平均:

6.2 熵和交叉熵

熵(Entropy)

熵衡量的是随机变量的不确定性,即在给定概率分布

- 解释:

- 熵越高,意味着事件的不确定性越大(例如,一个公平的硬币有更高的不确定性)。

- 熵越低,意味着事件的确定性越高(例如,一个总是正面的硬币熵为 0)。

交叉熵(Cross-Entropy)

交叉熵衡量的是用一个分布

- 解释:

- 交叉熵用于评估一个预测分布

- 如果

- 交叉熵越小,说明预测分布

- 交叉熵用于评估一个预测分布

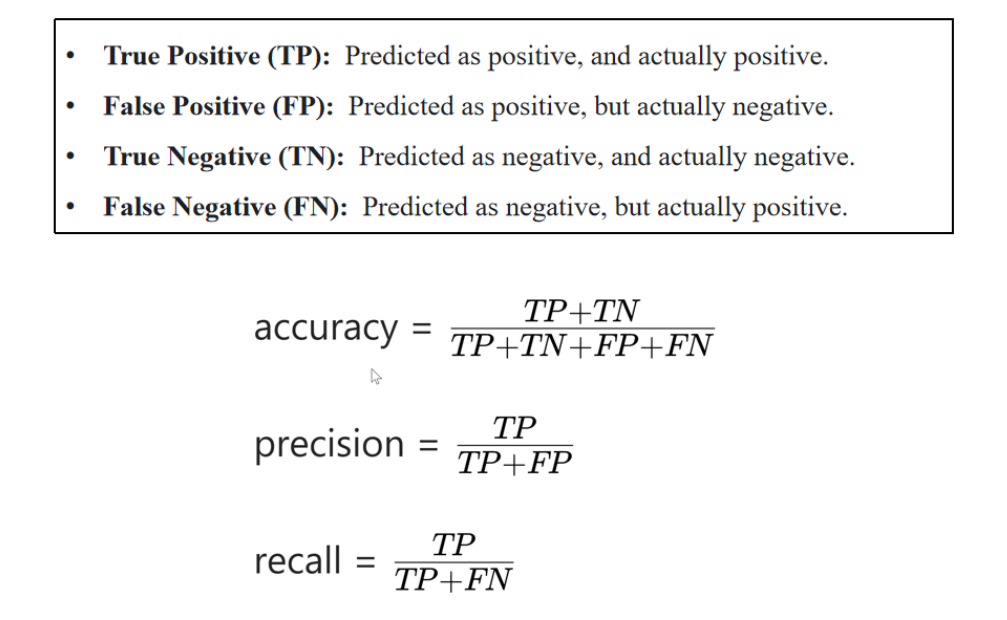

7. evaluate models

实操

下载数据集,实现分类任务

下载数据集:

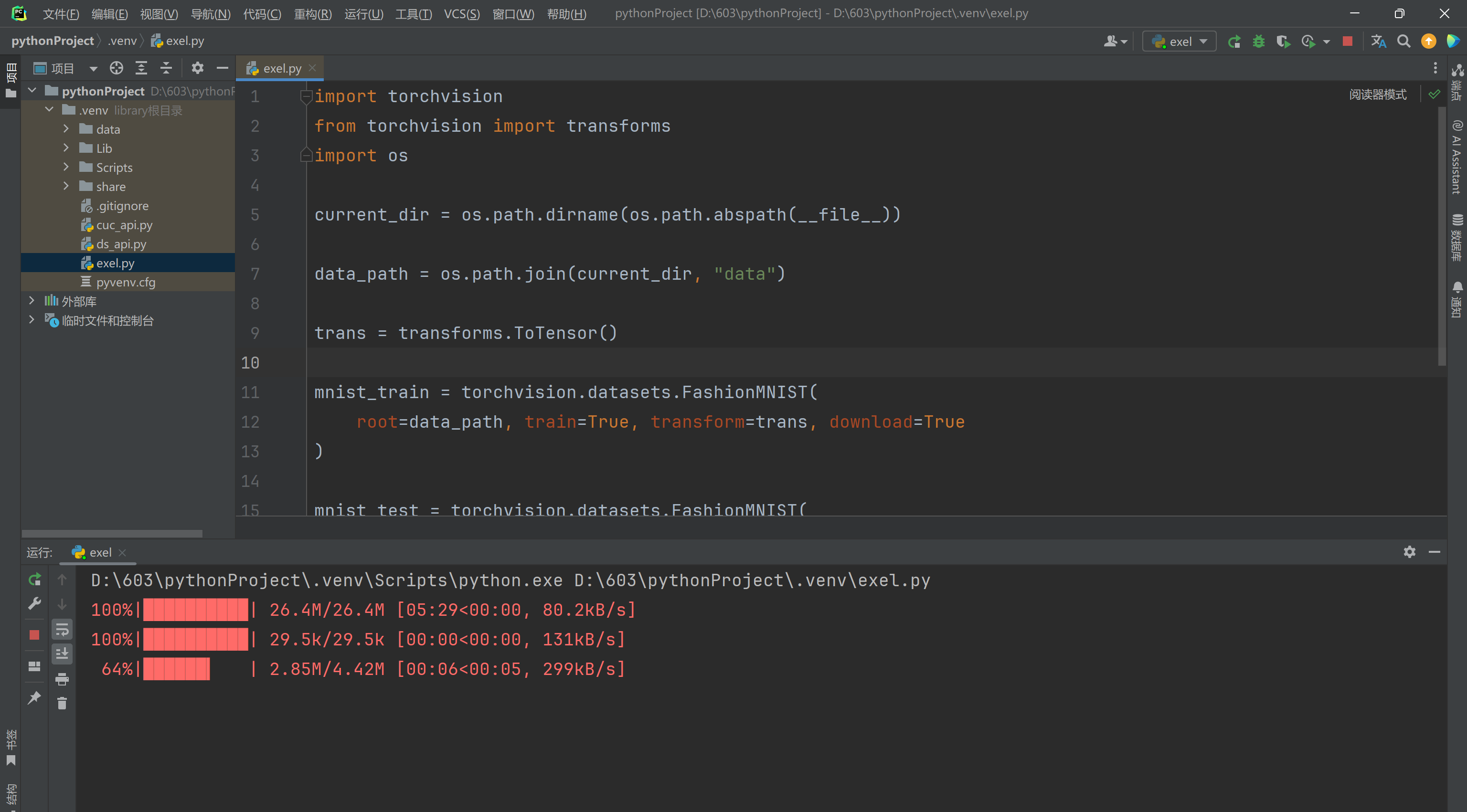

import torchvision

from torchvision import transforms

import os

current_dir = os.path.dirname(os.path.abspath(__file__))

data_path = os.path.join(current_dir, "data")

trans = transforms.ToTensor()

mnist_train = torchvision.datasets.FashionMNIST(

root=data_path, train=True, transform=trans, download=True

)

mnist_test = torchvision.datasets.FashionMNIST(

root=data_path, train=False, transform=trans, download=True

)